影像融合目前在前列腺癌的诊断中发挥着重要作用,选择和开发出良好的影像融合算法是实现影像融合的核心任务,决定了所得到的融合图像质量是否优良,是否能满足临床应用的实际需求,因此成为医学图像融合的研究热点之一。为了对医学影像融合方法进行全面研究,本文对近年来国内外发表的相关文献进行综述。对影像融合技术进行分类,将影像融合算法分为传统融合算法和深度学习融合算法,对一些算法的原理和工作流程进行深入分析对比,总结其优缺点,并介绍了相关的医学影像数据集。最后,本文对医学影像融合算法的未来发展趋势进行了展望,为医学影像融合技术辅助诊断前列腺癌等重大疾病指明了发展方向。

引用本文: 罗文斌, 王沛, 张一伟, 石更强. 基于影像融合诊断前列腺癌的研究进展. 生物医学工程学杂志, 2024, 41(5): 1078-1084. doi: 10.7507/1001-5515.202403054 复制

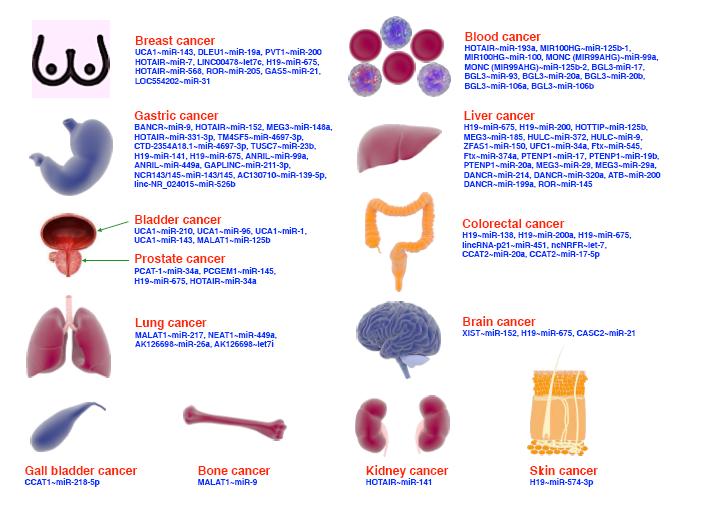

0 引言

近年来,前列腺癌(prostate cancer,PCa)发病率在全球范围内呈上升趋势,给前列腺癌的诊断带来巨大的挑战[1]。在临床上,前列腺癌的可疑区域可由医学影像呈现出来,医生常借助影像资料辅助前列腺穿刺活检,这是诊断前列腺癌的常用方法,但是仅通过单模态的前列腺影像来评估患者是否患有前列腺癌,容易引起漏诊、假阳性等问题[2]。因此,为进一步提高前列腺癌的诊断率,医学上逐渐将前列腺癌的诊断与人工智能(artificial intelligence,AI)相结合,通过机器学习(machine learning,ML)将多种模态的前列腺影像进行融合,取得了巨大的成功。许多学者提出影像融合技术的构想,通过计算机技术将不同模态影像中的图像信息整理融合到同一张医学图像中。此图像被称作融合图像,从融合图像中可以得到病变区域的丰富信息,从而辅助前列腺穿刺以提高穿刺成功率。融合影像辅助前列腺癌诊断的关键是医学图像融合效果,而融合算法的优劣则是影响融合效果的重要因素。

1 医学影像模态

常见的影像模态有超声(ultrasound,US)、核磁共振(magnetic resonance imaging,MRI)、计算机断层扫描(computed tomography,CT)、正电子发射断层成像(positron emission tomography,PET)和单光子发射计算机断层成像(single-photon emission computed tomography,SPECT)等[3]。而在前列腺癌的诊断过程中,常采用MRI和US两种成像,以引导前列腺穿刺手术的进行。

1.1 单模态影像

单模态影像在医学影像学中通常指采用单一技术来获取患者体内的影像信息。在前列腺癌的诊断中,MRI成像清晰,图像完整,但有时会出现伪影且耗时较长,在对患者的前列腺进行MRI检查时,得到单模态的MRI,此时医生对病灶位置的把握过于依赖临床经验,易造成漏诊。在前列腺穿刺中,医生手握超声探头在患者检查部位实时移动,US成像便捷迅速、实时性好,但得到的图像分辨率较低,组织的结构边缘较为模糊,导致前列腺上的肿瘤病灶难以被发现。因此,单模态图像辅助诊断前列腺癌,对医生的临床经验依赖性较大,难以精确找到病灶,应寻找更为有效的穿刺技术以实现精确诊断。

1.2 融合影像

影像融合是指将两种或两种以上的医学图像,经过计算机影像处理技术后,最大限度整理各自有效信息融合成高质量影像的过程[4]。而医学影像融合通常分两种,即认知融合与基于人工智能的多模态影像融合[5]。前者既依赖医生的临床经验又耗时费力,诊断结果存在主观性和延后性;后者通过融合算法将不同的单模态影像进行融合,得到融合图像,既提高了影像的质量,又降低了时间成本。

以前列腺影像融合为例,实际筛查前列腺癌时,通常是在融合影像的引导下,完成前列腺穿刺活检手术。例如Masaya等[6]、Nam等[7]和Claros等[8]为探究前列腺图像人工智能融合较认知融合对前列腺癌检出率更高的猜想,由泌尿科医生先后采用图像融合系统和MRI/US认知融合方式对患者进行穿刺,对两种融合方式的检出率数据进行分析对比,并深入分析认知融合和人工智能辅助融合各自的特点以及未来图像融合发展趋势。结果发现,经计算机技术处理得到的融合影像能够提供更精准的前列腺可疑区病灶,认知融合则主要凭借医生长期的临床经验,结合前列腺医学图像以完成前列腺的穿刺活检。

2 医学影像融合方法

为了提高前列腺癌的诊断率,进行前列腺多模态图像融合是良好的选择。从医学信息融合技术的角度,多模态医学图像融合(multimodal medical image fusion,MMIF)方法包括传统融合方法和基于深度学习的融合方法。为进一步探讨各类多模态医学图像融合方法的区别,围绕传统融合和基于深度学习融合两个方面,从频率域、空间域、基于深度学习的卷积神经网络(convolutional neural networks,CNN)与生成对抗网络(generative adversarial networks,GAN)等四个方面进行论述。

2.1 频率域融合

频率域的融合策略是利用傅里叶变换(Fourier transform,FT)将源图像转换至频域,然后融合这些频域分量,最后再进行逆傅里叶变换得到融合图像。频率域变换实则是对源图像分解后的频率系数进行运算,前列腺图像频率域变换融合过程如图1a所示。

图1

前列腺图像在两类传统变换域中的融合过程

图1

前列腺图像在两类传统变换域中的融合过程

a. 频率域变换融合;b. 空间域方法融合

Figure1. Fusion process of prostate images in two kinds of traditional transformation domainsa. frequency domain transform fusion; b. spatial domain method fusion

金字塔变换(tower-type filter,TTF)是常见的变换域融合算法之一,过程如图2a所示,通过行列矩阵对图像间隔采样得到许多分辨率逐步降低的图像,由于图像经分解后低分辨率系数和高分辨率系数分离,因此图像特征和细节信息比较突出。在医学图像融合过程中,金字塔变换较为常见,例如,拉普拉斯金字塔、斜率金字塔和形态学金字塔等[9]。这些算法运算效率高,融合图像存在一定优势。但是,这种融合方法也存在一些劣势,比如分解方向不明确、分解冗余,以及随着分解层数增加,分辨率降低,图像边界愈发模糊。

图2

前列腺图像在两种常见变换域的融合过程

图2

前列腺图像在两种常见变换域的融合过程

a. 金字塔变换图像融合;b. 小波变换图像融合

Figure2. Fusion process of prostate images in two common transform domainsa. pyramid transform image fusion; b. wavelet transform image fusion

很快,小波变换(wavelet transform,WT)的出现弥补了金字塔变换的不足。小波变换如图2b所示,将医学图像分解为代表轮廓边缘的低频系数和代表图像细节的多层三维高频系数,可清晰反映图像的局部特征变化,分解图像无信息冗余,分解方向明确,弥补了金字塔变换的劣势[10]。例如Syed等[11]采用优化小波变换算法对图像进行分解,构建优化小波变换模型,最后进行逆优化小波变换重建医学图像,在对各种成像数据集进行评估后,验证了该模型的有效性。还有张鲁等[12]也提出了一种改良小波变换网络模型,该模型由小波变换改造而来,保留了更多的频率细节。值得注意的是,小波变换作为一种多模态融合方法,对医学图像的变换体现了良好的方向性,得到了大多数的频率信息,但无法选择变换的方向,也无法保持变换过程中的平移不变性,因此常与其他频率域变换法结合使用。例如,将轮廓波、曲线波与小波变换结合处理图像既继承了分解方向明确的优势,又具备了分解图像时平移的不变性。Kumar等[13]将非下采样轮廓波变换与平稳WT结合构建融合模型,对该模型进行了视觉分析和定量比较,得到的融合图像与源图像别无二致,并且图像边缘更加清晰,实现了图像分解时平移不变性的目标。另外,Jamwal等[14]也提出了曲线波变换与脊波小波变换的多模态融合模型,通过相关CT和MRI的数据集评价和验证了该模型可保留关键信息、提高图像质量的优势,超过了单独的小波变换。

2.2 空间域方法

空间域融合的基本策略是在图像的像素上运行,因它在源图像上进行,因此得到的融合图像信噪比(signal to interference plus noise ratio,SINR)低、保真度高。以前列腺US图像融合为例,其空间域融合过程如图1b所示。目前该域内的方法有强度/色相饱和度法、简单最大/最小值法、独立成分分析法(independent component analysis,ICA)、主成分分析法(principal component analysis,PCA)、加权平均法等[9]。

最大值法和加权平均法是图像融合最简便的方法,运算快、操作简单,但得到的图像边缘轮廓模糊不清,失真明显。独立成分分析法是一种用于从混合信号中分离出原始独立成分的信号处理算法,对源图像进行分解,最后将得到的分量融合成图像。而主成分分析法则是分解源图像,提取主要成分融合图像,这两种方法的取向偏重不同。主成分分析法作为一种空间域经典算法,将图像高维数据转换为低维数据,同时保留原始数据的大部分信息,将降低维度后的信息进行融合。Mohan等[15]提出平稳小波变换与主成分分析相结合融合图像,在一定程度上呈现了保持边缘持久性、图像移位不变性、分辨率高的效果。

2.3 深度学习方法

近年来,随着人工智能的兴起,深度学习涉及了众多领域,尤其在医学图像处理领域取得了巨大的成功。基于深度学习的融合方法大多是基于CNN和基于GAN的融合,这些网络经过训练和调优后,获得了良好的输入特征[16]。

2.3.1 卷积神经网络方法

基于CNN融合的方法克服了传统融合方法在设计复杂特征提取和分类方法上的困难。CNN框架是由众多的卷积层、池化层和全连接层组成的,它可以高效处理前列腺图像的领域空间与结构信息[17]。在CNN中,每层都由若干个特征映射组成,这些映射特征被称为神经元。在多模态图像融合方面,开发了很多基于CNN框架的源图像获取权重图。Paralic等[18]提出了一种新的基于CNN的方法,将空间数据转换处理系统(feature manipulate engine,FME)和迁移学习(transfer learning,TL)的概念融入图像处理模块中,生成多个增强通道,以有效捕获COVID-19感染图像特有的光照和纹理的微小变化特征。Jin等[19]提出基于多目标差分进化和Xception模型的多模态生物医学融合模型,使用多目标差分进化提取最优特征,利用确定系数和基于能量损失的融合函数增强融合效果,与目前最佳的方法相比,在边缘强度、融合对称性、融合因子、互信息分析等方面分别高出1.692 8%、1.197 4%、1.392 8%、1.837 3%。Chen等[20]介绍了利用3DCNN和卷积长短期记忆网络相结合的方法来检测肿瘤,不仅提高了诊断精度,而且有望推动医学图像分析领域的发展。但其不足性也很明显,比如数据训练无针对性、耗时长,基于前列腺医学图像的特殊性,一种CNN往往适用于一种医学图像的融合,因此,开发出一种普遍适用的融合方法是目前研究的难点。

2.3.2 生成对抗网络方法

GAN也是深度学习中的一种生成模型,与CNN不同的是,GAN通过对抗学习机制进行训练并对医学图像中的显著信息建模[15]。不同模态医学图像的特征信息不同,为解决融合过程的域差异问题,许多研究者提出了基于GAN网络框架的融合算法,以增强融合效果。Nabil等[21]提出一种基于GAN的可见光与红外图像融合的方法,解决了GAN容易忽略可见光对比度信息和细节红外纹理信息的问题,提高了融合图像的质量。Qian等[22]提出一种基于多尺度变换(multi-scale transformation,MST)和GAN的图像融合框架,该框架提高了融合结果的对比度。GAN通过两个神经网络相互博弈进行学习,可在不使用标注数据的基础上进行生成任务的学习,在持续对抗、不断学习中,最终实现医学图像的融合。总体而言,GAN方法融合效果良好,但图像细节信息易被其他信息掩盖,其对抗系统也缺乏稳定性。基于深度学习的融合方法通常是在配准好的源图像上进行的,但实际中的源图像均是未配准的。因此,现有的深度学习方法并不适用于直接对源图像进行融合。在使用深度学习处理图像前,一般会对源图像进行配准,但执行配准的算法也存在自身的局限性,比如耗时长、配准精度低等。再者,由于成像方式不一,源图像分辨率亦有差异。克服不同分辨率、充分综合多模态图像中的信息实现良好融合是目前研究的一个难点。综上所述,多模态医学图像融合技术对比详见表1。

3 相关医学影像数据集及图像质量评价指标

3.1 相关医学影像数据集

在前列腺的多模态图像融合任务中,研究者往往需要大量数据进行算法模型的验证,在医学上常见的数据集有Open Access Series of Imaging Studies(OASIS)、The Cancer Imaging Archive(TCIA)、Alzheimer’s Disease Neuroimaging Initiative(ADNI)和Medical Information Data Analysis System(MIDAS)数据集(见表2)。研究者常采用公开的免费数据集TCIA,以完成算法模型的验证并对各种融合技术进行融合性能评估[23-25]。

3.2 图像质量评价指标

无论使用何种图像融合方法,均需经过图像分解、融合规则、图像重构等过程。执行以上任务时,对图像的特征提取、压缩、传输和重建过程容易引起伪影、失真、过度增强等问题[26]。因此,需要通过特定的图像质量评估(image quality assessment,IQA)方法来评判图像融合技术的优劣,评估方法可分为定性评估和定量评估两大类。

3.2.1 定性分析

在医学图像融合中,所谓定性分析是指通过人的视觉感受和视觉分析来评估融合图像的质量。这种主观的评估方法不使用任何模型技术,单纯依靠评估者的视觉感受和所发表的意见对融合图像质量进行点评。考虑到图像大小、空间细节、颜色等参数,此方法在许多实际融合中并不适用,因为这将导致价格昂贵、耗时、操作不便等问题。

3.2.2 定量评价

此分析法基于算法模型,采用一些评价指标,从客观上定量考校融合图像的质量,这些评价指标根据参考图像的适用性可进一步分为参考指标和非参考指标[27-35]。参考指标包括互信息(mutual information,MI)、结构相似指数测量(structural similarity index measure,SSIM)、特征互信息(feature mutual information,FMI)、通用图像质量指数(universal image quality index,UIQI)、峰值信噪比(peak signal to noise ratio,PSNR)。非参考指标包括熵(entropy,EN)、标准偏差(standard deviation,SD)、空间频率(spatial frequency,SF)、平均梯度(average gradient,AG)。各评价指标的具体公式及说明参见附件1。

在上述参考指标中,MI用于衡量融合图像与原始图像之间的相似程度,可以量化图像融合的质量,帮助优化图像融合算法,以实现更好的融合效果;SSIM则旨在测量两幅图像之间的结构相似性,特别是在评估图像结构信息的保留与重建时极具优势;FMI结合了互信息和特征表示的特点,提供一种更细粒度的图像相似性度量方式来反映图像融合后的特征保留程度;至于UIQI,它结合了亮度、对比度和结构信息,旨在提供一个全面的图像质量度量对图像融合的效果进行全面的评估,以达到更好的融合效果;此外,PSNR主要基于图像的像素值比较,而对图像的亮度、对比度和结构等特征以及特定类型的失真并不敏感,因此在评价图像融合质量时,还应结合其他指标来进行综合考量,以获得更全面的评价结果。

在前述非参考指标中,EN反映了图像中的信息量,常被用来衡量图像的复杂度或信息量;SD则常被用来评估图像的对比度或灰度分布的分散程度;此外,SF分析提供一种直观的方式来理解图像中的空间结构变化,但某些情况下一些融合方法可能会导致SF的变化,会引入不自然或不希望的视觉效果,这就需要结合其他评价指标进行综合考量;AG常用于衡量图像的清晰度或边缘的锐利程度,通过比较融合前后图像的AG值,可以了解融合是否导致了图像细节的丢失或边缘的模糊,从而评估融合的效果。

4 总结与展望

本文以前列腺癌的诊断为背景,主要讨论了在前列腺癌诊断中影像融合的技术问题。首先,文章描述了多模态图像融合过程使用的影像模态。之后讨论了不同的影像融合方法,描述了一些融合规则的工作流程。从影像融合的频率域、空间域、深度学习这三个方面,深入分析比较了各种融合方法的优劣。融合图像的质量评估可采用一系列评估指标进行判断。在本综述中,深度学习融合和混合融合的方法相结合比其他融合法更令人满意,但是在决定哪种融合方法最适合具体病症时,要考虑许多因素,因此不能草率决定哪种方法最好,要具体情况具体分析。

本文讨论了多种多模态影像融合技术。其中,主成分分析算法的计算效率虽然简单快速,但它易导致图像光谱受损。频域融合比标准化融合取得的效果要好,可减少频谱失真,但是这类技术带来了更大的信噪比。在以往的经验中,二次融合可以达到图像增强的效果,但是经过二次融合后,融合图像的空间分辨率可能降低。整理文献发现,混合融合方法可改良融合图像的对比度、清晰度、纹理和边缘信息,也能够从源图像中捕捉互补信息。即便如此,依旧需要对每种多模态融合方法十分熟悉,进而改进混合融合技术,以期得到非均匀的融合图像,只是这些技术开发困难,耗时过久。混合融合方法的另一个劣势是不适合运算大型的数据集。在稀疏表示法中,稀疏系数是衡量融合效果的关键参数。为充分保留源图像的细节信息和图像边缘结构,可以通过增强图像对比度和保留视觉信息的方式实现。但是,该技术也面临更多的挑战,比如存在注册错误,几乎没有保存图像细节的能力。深度学习为优化融合过程提供了技术支撑,能根据具体的要求构建算法模型。当面临多个大型数据集时,深度学习的处理能力优于其他融合技术。但是深度学习融合图像是一个复杂的多参数动态过程,对硬件设备要求高,训练一个模型耗时长,而且深度学习算法不适用于小的图像数据集。

虽然研究者已经提出了数种医学图像融合办法,但是这些办法依旧存在改进空间。实际临床应用所需的新的多模态医学影像融合技术和图像融合指标还需要深入研究。基于上述不足,对未来研究的建议如下。首先,研究者应当探索新的图像表示方法和公认的图像评估指标,研究图像融合技术的有效性,以推进机器学习中深度学习的进一步发展。其次,在融合前,要通过不断发展的方法来增强源图像的感兴趣区域。在面对实际的医学图像融合问题时,需要研究新的多尺度变换算法用于医学图像融合,以及寻找更强大的无参考指标以评估融合图像的质量。此外,还需改进图像融合质量输出,控制好图像的噪声。最后,每种医学成像都会缺少一定信息并含有噪声,具有计算成本,不同模态的图像尺寸不同,应该确定合适的解决方案。

重要声明

利益冲突声明:本文全体作者均声明不存在利益冲突。

作者贡献声明:石更强负责论文指导和审阅;罗文斌负责论文写作与修改;王沛负责查阅与分析文献;张一伟负责制表与画图。

本文附件见本刊网站的电子版本(biomedeng.cn)。

0 引言

近年来,前列腺癌(prostate cancer,PCa)发病率在全球范围内呈上升趋势,给前列腺癌的诊断带来巨大的挑战[1]。在临床上,前列腺癌的可疑区域可由医学影像呈现出来,医生常借助影像资料辅助前列腺穿刺活检,这是诊断前列腺癌的常用方法,但是仅通过单模态的前列腺影像来评估患者是否患有前列腺癌,容易引起漏诊、假阳性等问题[2]。因此,为进一步提高前列腺癌的诊断率,医学上逐渐将前列腺癌的诊断与人工智能(artificial intelligence,AI)相结合,通过机器学习(machine learning,ML)将多种模态的前列腺影像进行融合,取得了巨大的成功。许多学者提出影像融合技术的构想,通过计算机技术将不同模态影像中的图像信息整理融合到同一张医学图像中。此图像被称作融合图像,从融合图像中可以得到病变区域的丰富信息,从而辅助前列腺穿刺以提高穿刺成功率。融合影像辅助前列腺癌诊断的关键是医学图像融合效果,而融合算法的优劣则是影响融合效果的重要因素。

1 医学影像模态

常见的影像模态有超声(ultrasound,US)、核磁共振(magnetic resonance imaging,MRI)、计算机断层扫描(computed tomography,CT)、正电子发射断层成像(positron emission tomography,PET)和单光子发射计算机断层成像(single-photon emission computed tomography,SPECT)等[3]。而在前列腺癌的诊断过程中,常采用MRI和US两种成像,以引导前列腺穿刺手术的进行。

1.1 单模态影像

单模态影像在医学影像学中通常指采用单一技术来获取患者体内的影像信息。在前列腺癌的诊断中,MRI成像清晰,图像完整,但有时会出现伪影且耗时较长,在对患者的前列腺进行MRI检查时,得到单模态的MRI,此时医生对病灶位置的把握过于依赖临床经验,易造成漏诊。在前列腺穿刺中,医生手握超声探头在患者检查部位实时移动,US成像便捷迅速、实时性好,但得到的图像分辨率较低,组织的结构边缘较为模糊,导致前列腺上的肿瘤病灶难以被发现。因此,单模态图像辅助诊断前列腺癌,对医生的临床经验依赖性较大,难以精确找到病灶,应寻找更为有效的穿刺技术以实现精确诊断。

1.2 融合影像

影像融合是指将两种或两种以上的医学图像,经过计算机影像处理技术后,最大限度整理各自有效信息融合成高质量影像的过程[4]。而医学影像融合通常分两种,即认知融合与基于人工智能的多模态影像融合[5]。前者既依赖医生的临床经验又耗时费力,诊断结果存在主观性和延后性;后者通过融合算法将不同的单模态影像进行融合,得到融合图像,既提高了影像的质量,又降低了时间成本。

以前列腺影像融合为例,实际筛查前列腺癌时,通常是在融合影像的引导下,完成前列腺穿刺活检手术。例如Masaya等[6]、Nam等[7]和Claros等[8]为探究前列腺图像人工智能融合较认知融合对前列腺癌检出率更高的猜想,由泌尿科医生先后采用图像融合系统和MRI/US认知融合方式对患者进行穿刺,对两种融合方式的检出率数据进行分析对比,并深入分析认知融合和人工智能辅助融合各自的特点以及未来图像融合发展趋势。结果发现,经计算机技术处理得到的融合影像能够提供更精准的前列腺可疑区病灶,认知融合则主要凭借医生长期的临床经验,结合前列腺医学图像以完成前列腺的穿刺活检。

2 医学影像融合方法

为了提高前列腺癌的诊断率,进行前列腺多模态图像融合是良好的选择。从医学信息融合技术的角度,多模态医学图像融合(multimodal medical image fusion,MMIF)方法包括传统融合方法和基于深度学习的融合方法。为进一步探讨各类多模态医学图像融合方法的区别,围绕传统融合和基于深度学习融合两个方面,从频率域、空间域、基于深度学习的卷积神经网络(convolutional neural networks,CNN)与生成对抗网络(generative adversarial networks,GAN)等四个方面进行论述。

2.1 频率域融合

频率域的融合策略是利用傅里叶变换(Fourier transform,FT)将源图像转换至频域,然后融合这些频域分量,最后再进行逆傅里叶变换得到融合图像。频率域变换实则是对源图像分解后的频率系数进行运算,前列腺图像频率域变换融合过程如图1a所示。

图1

前列腺图像在两类传统变换域中的融合过程

图1

前列腺图像在两类传统变换域中的融合过程

a. 频率域变换融合;b. 空间域方法融合

Figure1. Fusion process of prostate images in two kinds of traditional transformation domainsa. frequency domain transform fusion; b. spatial domain method fusion

金字塔变换(tower-type filter,TTF)是常见的变换域融合算法之一,过程如图2a所示,通过行列矩阵对图像间隔采样得到许多分辨率逐步降低的图像,由于图像经分解后低分辨率系数和高分辨率系数分离,因此图像特征和细节信息比较突出。在医学图像融合过程中,金字塔变换较为常见,例如,拉普拉斯金字塔、斜率金字塔和形态学金字塔等[9]。这些算法运算效率高,融合图像存在一定优势。但是,这种融合方法也存在一些劣势,比如分解方向不明确、分解冗余,以及随着分解层数增加,分辨率降低,图像边界愈发模糊。

图2

前列腺图像在两种常见变换域的融合过程

图2

前列腺图像在两种常见变换域的融合过程

a. 金字塔变换图像融合;b. 小波变换图像融合

Figure2. Fusion process of prostate images in two common transform domainsa. pyramid transform image fusion; b. wavelet transform image fusion

很快,小波变换(wavelet transform,WT)的出现弥补了金字塔变换的不足。小波变换如图2b所示,将医学图像分解为代表轮廓边缘的低频系数和代表图像细节的多层三维高频系数,可清晰反映图像的局部特征变化,分解图像无信息冗余,分解方向明确,弥补了金字塔变换的劣势[10]。例如Syed等[11]采用优化小波变换算法对图像进行分解,构建优化小波变换模型,最后进行逆优化小波变换重建医学图像,在对各种成像数据集进行评估后,验证了该模型的有效性。还有张鲁等[12]也提出了一种改良小波变换网络模型,该模型由小波变换改造而来,保留了更多的频率细节。值得注意的是,小波变换作为一种多模态融合方法,对医学图像的变换体现了良好的方向性,得到了大多数的频率信息,但无法选择变换的方向,也无法保持变换过程中的平移不变性,因此常与其他频率域变换法结合使用。例如,将轮廓波、曲线波与小波变换结合处理图像既继承了分解方向明确的优势,又具备了分解图像时平移的不变性。Kumar等[13]将非下采样轮廓波变换与平稳WT结合构建融合模型,对该模型进行了视觉分析和定量比较,得到的融合图像与源图像别无二致,并且图像边缘更加清晰,实现了图像分解时平移不变性的目标。另外,Jamwal等[14]也提出了曲线波变换与脊波小波变换的多模态融合模型,通过相关CT和MRI的数据集评价和验证了该模型可保留关键信息、提高图像质量的优势,超过了单独的小波变换。

2.2 空间域方法

空间域融合的基本策略是在图像的像素上运行,因它在源图像上进行,因此得到的融合图像信噪比(signal to interference plus noise ratio,SINR)低、保真度高。以前列腺US图像融合为例,其空间域融合过程如图1b所示。目前该域内的方法有强度/色相饱和度法、简单最大/最小值法、独立成分分析法(independent component analysis,ICA)、主成分分析法(principal component analysis,PCA)、加权平均法等[9]。

最大值法和加权平均法是图像融合最简便的方法,运算快、操作简单,但得到的图像边缘轮廓模糊不清,失真明显。独立成分分析法是一种用于从混合信号中分离出原始独立成分的信号处理算法,对源图像进行分解,最后将得到的分量融合成图像。而主成分分析法则是分解源图像,提取主要成分融合图像,这两种方法的取向偏重不同。主成分分析法作为一种空间域经典算法,将图像高维数据转换为低维数据,同时保留原始数据的大部分信息,将降低维度后的信息进行融合。Mohan等[15]提出平稳小波变换与主成分分析相结合融合图像,在一定程度上呈现了保持边缘持久性、图像移位不变性、分辨率高的效果。

2.3 深度学习方法

近年来,随着人工智能的兴起,深度学习涉及了众多领域,尤其在医学图像处理领域取得了巨大的成功。基于深度学习的融合方法大多是基于CNN和基于GAN的融合,这些网络经过训练和调优后,获得了良好的输入特征[16]。

2.3.1 卷积神经网络方法

基于CNN融合的方法克服了传统融合方法在设计复杂特征提取和分类方法上的困难。CNN框架是由众多的卷积层、池化层和全连接层组成的,它可以高效处理前列腺图像的领域空间与结构信息[17]。在CNN中,每层都由若干个特征映射组成,这些映射特征被称为神经元。在多模态图像融合方面,开发了很多基于CNN框架的源图像获取权重图。Paralic等[18]提出了一种新的基于CNN的方法,将空间数据转换处理系统(feature manipulate engine,FME)和迁移学习(transfer learning,TL)的概念融入图像处理模块中,生成多个增强通道,以有效捕获COVID-19感染图像特有的光照和纹理的微小变化特征。Jin等[19]提出基于多目标差分进化和Xception模型的多模态生物医学融合模型,使用多目标差分进化提取最优特征,利用确定系数和基于能量损失的融合函数增强融合效果,与目前最佳的方法相比,在边缘强度、融合对称性、融合因子、互信息分析等方面分别高出1.692 8%、1.197 4%、1.392 8%、1.837 3%。Chen等[20]介绍了利用3DCNN和卷积长短期记忆网络相结合的方法来检测肿瘤,不仅提高了诊断精度,而且有望推动医学图像分析领域的发展。但其不足性也很明显,比如数据训练无针对性、耗时长,基于前列腺医学图像的特殊性,一种CNN往往适用于一种医学图像的融合,因此,开发出一种普遍适用的融合方法是目前研究的难点。

2.3.2 生成对抗网络方法

GAN也是深度学习中的一种生成模型,与CNN不同的是,GAN通过对抗学习机制进行训练并对医学图像中的显著信息建模[15]。不同模态医学图像的特征信息不同,为解决融合过程的域差异问题,许多研究者提出了基于GAN网络框架的融合算法,以增强融合效果。Nabil等[21]提出一种基于GAN的可见光与红外图像融合的方法,解决了GAN容易忽略可见光对比度信息和细节红外纹理信息的问题,提高了融合图像的质量。Qian等[22]提出一种基于多尺度变换(multi-scale transformation,MST)和GAN的图像融合框架,该框架提高了融合结果的对比度。GAN通过两个神经网络相互博弈进行学习,可在不使用标注数据的基础上进行生成任务的学习,在持续对抗、不断学习中,最终实现医学图像的融合。总体而言,GAN方法融合效果良好,但图像细节信息易被其他信息掩盖,其对抗系统也缺乏稳定性。基于深度学习的融合方法通常是在配准好的源图像上进行的,但实际中的源图像均是未配准的。因此,现有的深度学习方法并不适用于直接对源图像进行融合。在使用深度学习处理图像前,一般会对源图像进行配准,但执行配准的算法也存在自身的局限性,比如耗时长、配准精度低等。再者,由于成像方式不一,源图像分辨率亦有差异。克服不同分辨率、充分综合多模态图像中的信息实现良好融合是目前研究的一个难点。综上所述,多模态医学图像融合技术对比详见表1。

3 相关医学影像数据集及图像质量评价指标

3.1 相关医学影像数据集

在前列腺的多模态图像融合任务中,研究者往往需要大量数据进行算法模型的验证,在医学上常见的数据集有Open Access Series of Imaging Studies(OASIS)、The Cancer Imaging Archive(TCIA)、Alzheimer’s Disease Neuroimaging Initiative(ADNI)和Medical Information Data Analysis System(MIDAS)数据集(见表2)。研究者常采用公开的免费数据集TCIA,以完成算法模型的验证并对各种融合技术进行融合性能评估[23-25]。

3.2 图像质量评价指标

无论使用何种图像融合方法,均需经过图像分解、融合规则、图像重构等过程。执行以上任务时,对图像的特征提取、压缩、传输和重建过程容易引起伪影、失真、过度增强等问题[26]。因此,需要通过特定的图像质量评估(image quality assessment,IQA)方法来评判图像融合技术的优劣,评估方法可分为定性评估和定量评估两大类。

3.2.1 定性分析

在医学图像融合中,所谓定性分析是指通过人的视觉感受和视觉分析来评估融合图像的质量。这种主观的评估方法不使用任何模型技术,单纯依靠评估者的视觉感受和所发表的意见对融合图像质量进行点评。考虑到图像大小、空间细节、颜色等参数,此方法在许多实际融合中并不适用,因为这将导致价格昂贵、耗时、操作不便等问题。

3.2.2 定量评价

此分析法基于算法模型,采用一些评价指标,从客观上定量考校融合图像的质量,这些评价指标根据参考图像的适用性可进一步分为参考指标和非参考指标[27-35]。参考指标包括互信息(mutual information,MI)、结构相似指数测量(structural similarity index measure,SSIM)、特征互信息(feature mutual information,FMI)、通用图像质量指数(universal image quality index,UIQI)、峰值信噪比(peak signal to noise ratio,PSNR)。非参考指标包括熵(entropy,EN)、标准偏差(standard deviation,SD)、空间频率(spatial frequency,SF)、平均梯度(average gradient,AG)。各评价指标的具体公式及说明参见附件1。

在上述参考指标中,MI用于衡量融合图像与原始图像之间的相似程度,可以量化图像融合的质量,帮助优化图像融合算法,以实现更好的融合效果;SSIM则旨在测量两幅图像之间的结构相似性,特别是在评估图像结构信息的保留与重建时极具优势;FMI结合了互信息和特征表示的特点,提供一种更细粒度的图像相似性度量方式来反映图像融合后的特征保留程度;至于UIQI,它结合了亮度、对比度和结构信息,旨在提供一个全面的图像质量度量对图像融合的效果进行全面的评估,以达到更好的融合效果;此外,PSNR主要基于图像的像素值比较,而对图像的亮度、对比度和结构等特征以及特定类型的失真并不敏感,因此在评价图像融合质量时,还应结合其他指标来进行综合考量,以获得更全面的评价结果。

在前述非参考指标中,EN反映了图像中的信息量,常被用来衡量图像的复杂度或信息量;SD则常被用来评估图像的对比度或灰度分布的分散程度;此外,SF分析提供一种直观的方式来理解图像中的空间结构变化,但某些情况下一些融合方法可能会导致SF的变化,会引入不自然或不希望的视觉效果,这就需要结合其他评价指标进行综合考量;AG常用于衡量图像的清晰度或边缘的锐利程度,通过比较融合前后图像的AG值,可以了解融合是否导致了图像细节的丢失或边缘的模糊,从而评估融合的效果。

4 总结与展望

本文以前列腺癌的诊断为背景,主要讨论了在前列腺癌诊断中影像融合的技术问题。首先,文章描述了多模态图像融合过程使用的影像模态。之后讨论了不同的影像融合方法,描述了一些融合规则的工作流程。从影像融合的频率域、空间域、深度学习这三个方面,深入分析比较了各种融合方法的优劣。融合图像的质量评估可采用一系列评估指标进行判断。在本综述中,深度学习融合和混合融合的方法相结合比其他融合法更令人满意,但是在决定哪种融合方法最适合具体病症时,要考虑许多因素,因此不能草率决定哪种方法最好,要具体情况具体分析。

本文讨论了多种多模态影像融合技术。其中,主成分分析算法的计算效率虽然简单快速,但它易导致图像光谱受损。频域融合比标准化融合取得的效果要好,可减少频谱失真,但是这类技术带来了更大的信噪比。在以往的经验中,二次融合可以达到图像增强的效果,但是经过二次融合后,融合图像的空间分辨率可能降低。整理文献发现,混合融合方法可改良融合图像的对比度、清晰度、纹理和边缘信息,也能够从源图像中捕捉互补信息。即便如此,依旧需要对每种多模态融合方法十分熟悉,进而改进混合融合技术,以期得到非均匀的融合图像,只是这些技术开发困难,耗时过久。混合融合方法的另一个劣势是不适合运算大型的数据集。在稀疏表示法中,稀疏系数是衡量融合效果的关键参数。为充分保留源图像的细节信息和图像边缘结构,可以通过增强图像对比度和保留视觉信息的方式实现。但是,该技术也面临更多的挑战,比如存在注册错误,几乎没有保存图像细节的能力。深度学习为优化融合过程提供了技术支撑,能根据具体的要求构建算法模型。当面临多个大型数据集时,深度学习的处理能力优于其他融合技术。但是深度学习融合图像是一个复杂的多参数动态过程,对硬件设备要求高,训练一个模型耗时长,而且深度学习算法不适用于小的图像数据集。

虽然研究者已经提出了数种医学图像融合办法,但是这些办法依旧存在改进空间。实际临床应用所需的新的多模态医学影像融合技术和图像融合指标还需要深入研究。基于上述不足,对未来研究的建议如下。首先,研究者应当探索新的图像表示方法和公认的图像评估指标,研究图像融合技术的有效性,以推进机器学习中深度学习的进一步发展。其次,在融合前,要通过不断发展的方法来增强源图像的感兴趣区域。在面对实际的医学图像融合问题时,需要研究新的多尺度变换算法用于医学图像融合,以及寻找更强大的无参考指标以评估融合图像的质量。此外,还需改进图像融合质量输出,控制好图像的噪声。最后,每种医学成像都会缺少一定信息并含有噪声,具有计算成本,不同模态的图像尺寸不同,应该确定合适的解决方案。

重要声明

利益冲突声明:本文全体作者均声明不存在利益冲突。

作者贡献声明:石更强负责论文指导和审阅;罗文斌负责论文写作与修改;王沛负责查阅与分析文献;张一伟负责制表与画图。

本文附件见本刊网站的电子版本(biomedeng.cn)。